Piotr Guzik: Co skłoniło pana do sprawdzenia, jak bardzo człowiek może być posłuszny, jeśli polecenia będzie mu wydawać robot?

Prof. Tomasz Grzyb: Automaty otaczają nas coraz bardziej. Przykładem port lotniczy we Wrocławiu. Od pewnego czasu funkcjonują tam automatyczne bramki. Wchodzimy do specjalnej kabiny, w której odbywa się skanowanie paszportu, odczyt danych biometrycznych, kamera porównuje nasz wygląd ze zdjęciem z dokumentu. I to nie człowiek, a specjalnie opracowany program decyduje o tym, czy nas wpuścić, czy nie. Z czymś podobnym mogli się zetknąć ci, którym zawieszono konto w mediach społecznościowych. Tutaj bowiem też zazwyczaj nie jest to decyzja człowieka, a algorytmu, który za względu na zastosowanie we wpisie określonego słownictwa bądź zdjęć może ograniczyć dostęp do naszego konta ze względu na stwierdzenie naruszenia polityki portalu. To tylko przykłady obszarów, w jakich sztuczny byt przejmuje kontrolę nad naszym postępowaniem.

To, że decyduje za nas jakiś automat, może wzbudzać chęć do buntu.

– Eksperymenty Stanleya Milgrama z lat 60. i 70. pokazały, że większość ludzi jest bardzo posłuszna. Nawet, jeśli wiąże się to z robieniem krzywdy komuś innemu. Przypomnę, że w tych badaniach mieliśmy do czynienia postaciami nauczyciela, ucznia i eksperymentatora. Rolę nauczyciela dostawała osoba będąca w istocie obiektem badania. Jej zadaniem było rażenie prądem ucznia w sytuacji, jeśli popełnił błąd w wykonywanym zadaniu. Po każdym błędzie kolejna kara oznaczała podwyższenie napięcia impulsu elektrycznego, a więc i sprawienie większego bólu. Nauczycielowi towarzyszył eksperymentator, którego zadaniem było podkreślanie, że niezależnie od reakcji ucznia, procedurę należy kontynuować.

Ale tak naprawdę nikt nikogo prądem nie raził?

– Oczywiście, a uczeń był aktorem. W całym eksperymencie chodziło o sprawdzenie kiedy człowiek zbuntuje się i stwierdzi, że nie będzie robił krzywdy drugiemu tylko dlatego, że ktoś każe mu to czynić z pozycji autorytetu. Okazało się, że posłuszeństwo badanych było bardzo wysokie, sięgające nawet 90 procent. I teraz wracamy do genezy naszego eksperymentu. Mając na uwadze, że otacza nas coraz więcej automatów, postanowiliśmy sprawdzić, co by było, gdyby eksperymentatorem był nie człowiek, a robot. Bezduszna maszyna, która po prostu wydaje polecenia.

I co się okazało?

– Niezależnie od tego, czy polecenie kontynuowania procedury wydawał człowiek, czy robot, posłuszeństwo pozostało wysokie. W obu sytuacjach wyniosło około 90 procent. To przypadki, w których osoby będące nauczycielami pomimo wahań wymierzyły uczniowi maksymalną możliwą karę za popełnione błędy.

Dlaczego tak się stało?

– Hipotezy są dwie. Pierwsza zakłada, że uczestnicy eksperymentu podejmowali decyzje świadomie, w przekonaniu uczestnictwa w większym projekcie naukowym. Byli w laboratorium, sytuacja wyglądała poważnie, do tego towarzyszył im robot. Dla wielu osób była to pierwsza styczność z takim urządzeniem. Druga hipoteza – i ku niej bardziej się skłaniam – zakłada, że ludzie po prostu nie myśleli, wprowadzeni w stan bezrefleksyjności. Uznali, że skoro każe im się coś robić, to robią to. To daje pole do rozważań na temat tego, do jakiego stopnia zastanawiamy się nad swoim postępowaniem. Sporo z nas większość dnia działa – za przeproszeniem – na autopilocie.

Aż tak brak nam refleksji?

– Przytoczę sytuację, która z pozoru nie ma z tym tematem związku. Gdy zaczynam zajęcia ze studentami pierwszego roku, to podkreślam, że jako człowiek punktualny oczekuję od nich punktualności. Jeśli według planu wykład zaczyna się o godzinie 9.30, to o tej godzinie zamierzam go rozpoczynać. W tych wykładach uczestniczy około 250 osób. Trudno więc, aby ktoś się nie spóźnił. Gdy się to dzieje, mierzę taką osobę groźnym spojrzeniem. Mówię, że oczekiwałem punktualności. Po czym zwracam się do studentów, aby wybuczeli spóźnialskiego na moją komendę. I oni to robią. Wtedy pytam, dlaczego to zrobili. Przecież nie wiedzą, dlaczego ta osoba się spóźniła. Mogła mieć jakiś obiektywny powód, niezależny od niej.

Skąd to posłuszeństwo?

– Wpaja się je nam od najmłodszych lat. Na nim bazuje system szkolny. Szkoła uczy konformizmu. I oczywiście trudno mi sobie wyobrazić sytuację, kiedy w klasie mamy 30 indywidualistów. Tego i tak już obciążeni nauczyciele by nie znieśli. Ale są w życiu sytuacje, w których nie można się ślepo słuchać poleceń. Pamiętajmy jednak przy tym, że większość naszych codziennych relacji z ludźmi jest pozytywna. Nikt nie zmusza nas, byśmy innym robili krzywdę. I podobnie jest z automatami. Ogromna większość systemów ma nam pomagać w funkcjonowaniu. Przykładem zalgorytmizowane urządzenia obecne już na plażach w Stanach Zjednoczonych, które oceniają, czy można się kąpać, czy też nie jest to wskazane.

Zwolennicy teorii spiskowych mówią, że nawet takie automaty to krok ku zniewoleniu ludzi. Że to kolejny element tworzenia jakiegoś większego systemu kontroli.

– Tak zwykle reagujemy na rzeczy nowe i do tej pory nieznane. Kiedyś nawet wprowadzenie do Warszawy kanalizacji spowodowało pojawienie się spiskowych teorii. Powstała nawet broszura „Kanalizacja miasta Warszawy jako narzędzie judaizmu i szarlatanerii w celu zniszczenia rolnictwa polskiego oraz wytępienia ludności słowiańskiej nad Wisłą”. Trudno się zatem dziwić, że powszechna obecność sztucznej inteligencji rodzi podobne reakcje.

Automatom zdarza się jednak błędnie funkcjonować. Inne badania pokazały, że ludzie potrafią ich słuchać nawet wtedy, jeśli mają świadomość, że w przeszłości urządzeniom zdarzały się błędy. A nawet, gdy widzą, że one prowadzą ich na manowce.

– Maszyny są wadliwe, tak, jak i ludzie. Dlatego wracamy do tego, aby mieć w tym wszystkim własny rozum, a nie tylko ślepo wykonywać polecenia.

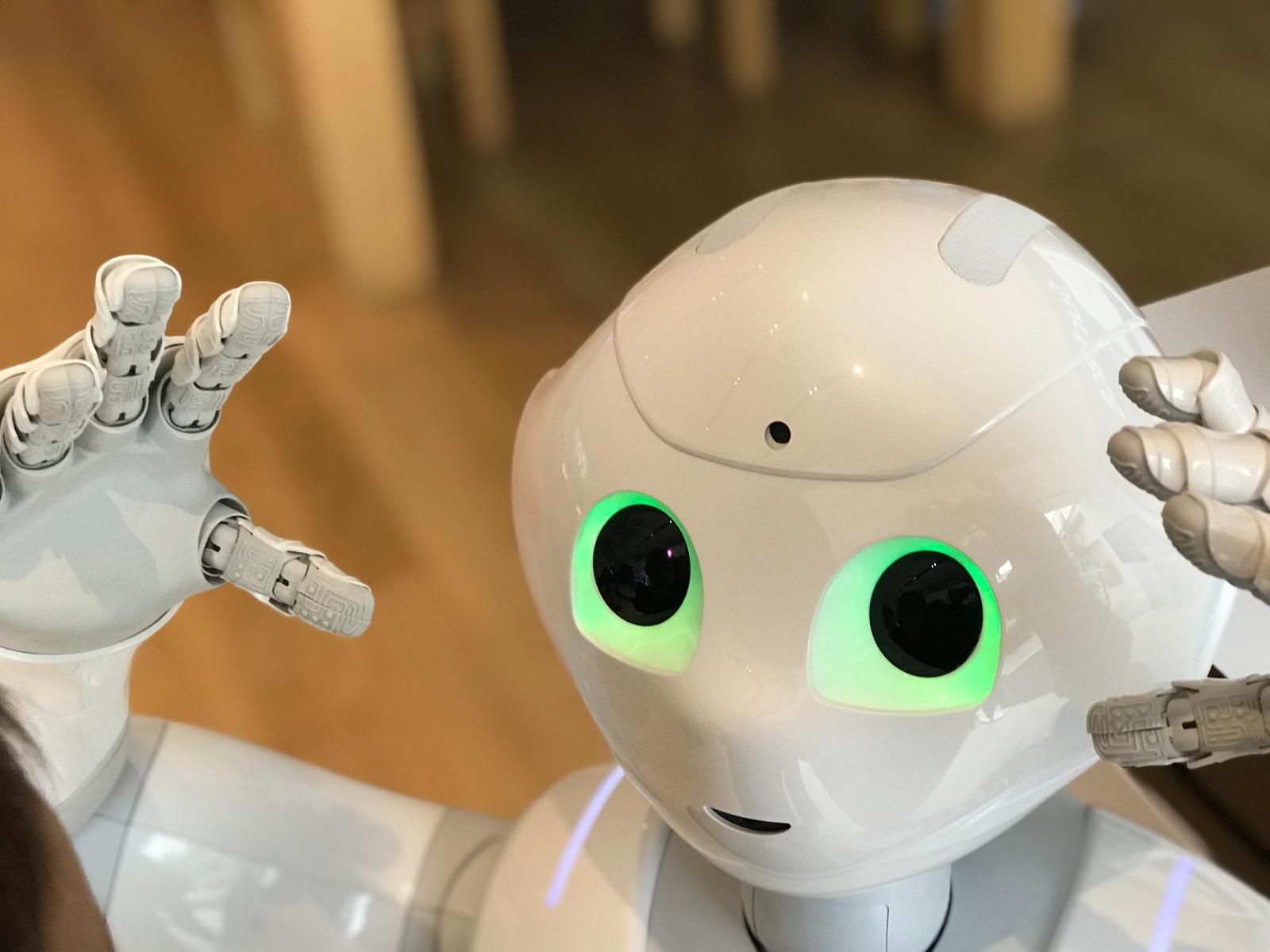

Robot, który był wykorzystany w pana badaniu to humanoidalny Pepper. Czy fakt, że uczestnikom eksperymentu polecenia wydawała maszyna przypominająca człowieka nie miał wpływu na ich poczynania?

– To jest cel kolejnego badania. Sprawdzenie, co by było, gdyby polecenia pojawiały się na ekranie komputera i płynęły z głośników na sali. Uczestnicy takiego badania nie mieliby do czynienia z namacalnym bytem, a czymś na kształt ChatuGPT. Czy mając świadomość, że polecenia wydają w istocie linie kodu, niewyobrażalnie długie ciągi zer i jedynek, a nie coś fizycznego, co przypomina nam drugiego człowieka, nadal bylibyśmy gotowi spełniać oczekiwania? To pytanie, na które będziemy chcieli odpowiedzieć.

Na tę chwilę wychodzi, że jeśli maszyny chciałyby nas sobie podporządkować, to wystarczy, aby były podobne do nas.

– Powstało dużo dystopijnych filmów science fiction na ten temat. I nie wykluczam, że jesteśmy blisko momentu, w którym maszyny przejmą kontrolę. Żeby jednak nie brzmieć fatalistycznie i nie malować wszystkiego w czarnych barwach, przypominam, że 10 proc. osób w badaniu odmówiło posłuszeństwa maszynie.

Ten odsetek nie jest budujący.

– Pokazuje jednak, że w każdej grupie znajdą się osoby gotowe przeciwstawić się czemuś, co uważają za niesłuszne. To sygnaliści, którzy wskazują, że coś jest nie w porządku. Należy ich doceniać. Owszem, działalność takich osób może przeszkadzać, ponieważ burzy ład i przekonanie, że wszystko jest w porządku. W historii świata takie osoby wyrządziły jednak znacznie mniej krzywd niż ci, co byli ślepo posłuszni.

Czytaj także: Sztuczna inteligencja pozwala niepełnosprawnym w Opolu normalnie żyć